ニュースや職場でたびたび耳にするビッグデータ。

ではビッグデータとはどんなデータでしょうか。データの数が多ければ、それをビッグデータと呼べるのでしょうか。

- データサイエンスを学び始めた方

- ビッグデータについて調べている方

目次

そもそもデータとは何か

データの定義は、時代や業界によって少し異なります。広辞苑では、

①立論・計算の基礎となる、既知のあるいは認容された事実・数値。資料。与件。

②コンピューターで処理する情報。

広辞苑

と定義されています。

データという言葉は、1640年代に初めて使用されました。データは「客観的で再現性のある事実や数値」を意味します。コンピュータが登場する以前は、言語や数値を資料に残し、情報を伝えられたらよかったのです。

20世紀にコンピュータが登場した後、IT技術分野の標準化を行う国際標準化機構の「ISO/IEC 2382-1」および日本工業規格の「X0001 情報処理用語-基本用語」では、データを、

“A reinterpretable representation of information in a formalized manner suitable for communication, interpretation, or processing.”「情報の表現であって、伝達、解釈または処理に適するように形式化され、再度情報として解釈できるもの」

Wikipedia, 「データ」より

と定めました。

現代のIT産業の視点では、

- コンピュータによって操作が実行される量、文字、または記号

- これらを電気信号の形式で保存および送信可能

- 磁気、光学、または機械の記録媒体に記録可能

これら3つの条件すべてを満たしたものを”データ”と呼びます。

感覚的に言うと、ビッグデータが扱うデータとは、デジタル化された情報ということですね。

ビッグデータとは何か

ビッグデータの条件も時代と共に少し変化しています。

実は、データの量が大きいだけのデータ群をビッグデータとは言えません。

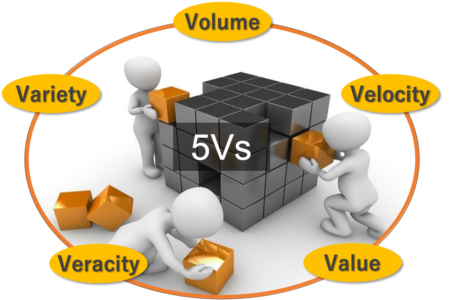

2000年代前半は、3V(Volume:量、Velocity:速度、Variety:種類)を満たすデータ群をビッグデータと呼びました。

しかし、その後、Veracity:信憑性、Value:価値、が加わり、最近では5Vを満たすデータ群をビッグデータと呼びます。

なるほど、データ量が大きいだけではビッグデータとは呼べないんですね!

ビッグデータの特徴

ビッグデータの条件である5Vについて解説します。

Volume:量

ビッグデータを定義するために、Volumeは重要な指標です。

特定のデータ群が実際にビッグデータとみなされるかどうかは、まずデータ量に依存します。ボリュームはビッグデータを扱う際に考慮すべき重要なポイントのひとつです。

一般的には、ビッグデータはテラバイト、ペタバイト以上のデータ量です。

Velocity:速度

Velocityは、データ生成や蓄積速度に関する指標です。需要を満たすために、データがどれ程速く生成され、送信されるかが、データが持つ実際の可能性を決めるために重要です。

例として、ビジネスプロセス、アプリケーションのログ、ネットワーク、ソーシャルネット、センサー、モバイルデバイスのようなデータソースから流れてくるデータを含んでいることがあげられます。これらのデータは膨大かつ継続的に得られます。

Variety:種類

Varietyは、特定のデータ群が異なるデータソースや性質を持つ構造化データと非構造化データの集まりであるかどうかが求められます。

以前は、スプレッドシートやデータベースに登録された構造化データのみが分析対象であり、考慮すべきデータソースは少なかったです。しかし、今日では、メール、写真、ビデオ、モニタリングデータ、音声、PDFなどの非構造化データも、分析に考慮すべき対象となりました。

これら多様なデータの集まりを解析のために利用することが新規性であり、ビッグデータの指標となります。

Veracity:信憑性

Veracityは、データの信憑性であり、品質/信頼性/整合性/正確性を指します。

ビッグデータの信憑性は、複数の異なるデータの型とデータソースから生じる影響によって変動します。大規模なデータは混乱を招く可能性が高まりますので、データの信憑性を確認する必要があります。

Value:価値

Valueはデータが意思決定にどれだけ役立つかを指します。大量のデータを得られても、そこから役に立つインサイトを得られないのであれば、そのデータに価値はありません。

適切な分析手法に基づき、ビッグデータから価値を抽出する必要があります。

バラエティに富んだ質の良いデータが、継続的に大量に蓄積され、そして、解析した結果に価値があるデータ群のことを「ビッグデータ」と呼びます。

ビッグデータの例

SNS:例えばFacebookでは1日におよそ500テラバイトのデータが蓄積されていると言われています。主にこれらのデータは、写真や動画のアップロード、メッセージやコメントのやりとりから生じています。

NY為替市場: 1日におよそ1テラバイトのデータが生成されています。

テラは1012で1兆倍です。1012円と表現すれば1兆円ですね。

なぜビッグデータが大事なのか

PC、スマホ、センサーなどのデバイスから生成されるデータ総量は増加を続けています。

5G、IoT、人工知能の発展により、データの生成速度はさらに上がると見込まれます。2020年5月、アメリカの市場調査会社「International Data Corporation (IDC)」は、”今後3年で生成されるデータ総量が過去30年で生成されたデータ総量を超える”とも予想しています。(1)(2)

データは“現代の石油“とも比喩されており、これらデータをうまく取り扱うことが、新たなサービスとイノベーションの源泉になると期待されており、世界中の企業や研究機関がビッグデータの活用に力を入れています。(3)

ビッグデータを利用するためにデータサイエンティストの需要もますます高まっています。

ビッグデータの重要性については、こちらの記事でも紹介させて頂いております。

まとめ

この記事ではビッグデータについてまとめました。

- ビッグデータとは5Vを満たすデータ群

- 5VとはVolume(量)、Velocity(速度)、Variety(種類), Veracity(信憑性), Value (価値)

- 今後生成されるデータ量はさらに増加、ビッグデータを活かすビジネスモデルの構築が必要

ありがとうございました!ビッグデータがどんなデータ群かよく分かりました!

今回は、データ量が多いだけではそのデータ群をビッグデータと言えない、と覚えていただけたたら十分です。

最後まで読んでいただきありがとうございました!

参考

3) The Economist, “The world’s most valuable resource is no longer oil, but data”, (5/6/2017)

この記事では「ビッグデータの定義」と「ビッグデータが注目されている理由」について解説します。